Numérique et Sciences Informatiques > Intelligence Artificielle (Notions de Base) > Éthique de l'IA > Responsabilité et transparence

Biais et Équité en Intelligence Artificielle

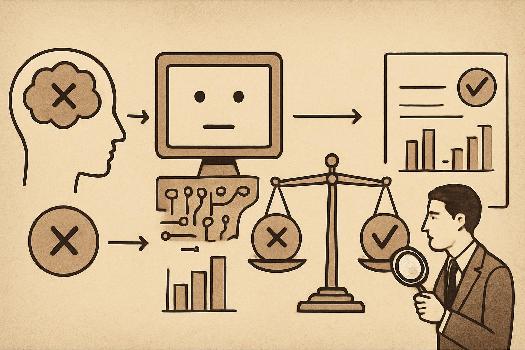

Explorez la problématique des biais dans les systèmes d'IA, leurs sources et leurs conséquences. Découvrez comment identifier et atténuer les biais pour garantir une IA plus équitable et juste.

Introduction aux Biais en IA

Les biais en IA se réfèrent aux discriminations systématiques et injustes présentes dans les systèmes d'intelligence artificielle. Ces biais peuvent conduire à des résultats inéquitables ou discriminatoires pour certains groupes de personnes.

Il est crucial de comprendre que les IA apprennent à partir des données qui leur sont fournies. Si ces données contiennent des biais (par exemple, des représentations disproportionnées de certains groupes), l'IA reproduira et même amplifiera ces biais dans ses décisions. Par exemple, si un algorithme de reconnaissance faciale est entraîné principalement avec des images de personnes blanches, il sera moins performant pour reconnaître les visages de personnes d'autres ethnies.

Sources des Biais en IA

Les biais peuvent s'infiltrer dans les systèmes d'IA à différentes étapes :

- Biais dans les données : Les données d'entraînement peuvent refléter des stéréotypes sociaux ou des inégalités existantes. Par exemple, les données historiques de recrutement peuvent contenir des biais sexistes, favorisant les hommes à certains postes.

- Biais dans les algorithmes : La conception même des algorithmes peut introduire des biais. Par exemple, certains algorithmes peuvent être plus sensibles à certaines caractéristiques, ce qui peut désavantager certains groupes.

- Biais dans la collecte des données : La façon dont les données sont collectées peut introduire des biais. Par exemple, si une enquête est menée uniquement auprès d'un certain groupe de personnes, les résultats ne seront pas représentatifs de l'ensemble de la population.

- Biais d'interprétation : La façon dont les résultats de l'IA sont interprétés et utilisés peut également introduire des biais. Par exemple, si les résultats d'un test de dépistage sont interprétés différemment selon l'origine ethnique de la personne testée.

Conséquences des Biais en IA

Les biais en IA peuvent avoir des conséquences graves dans de nombreux domaines :

- Justice : Les algorithmes utilisés dans le système judiciaire (par exemple, pour évaluer les risques de récidive) peuvent être biaisés et conduire à des peines plus sévères pour certains groupes.

- Santé : Les algorithmes de diagnostic médical peuvent être moins précis pour certains groupes de patients, ce qui peut entraîner des erreurs de diagnostic ou des retards de traitement.

- Emploi : Les algorithmes de recrutement peuvent discriminer certains candidats, limitant leurs chances d'obtenir un emploi.

- Finance : Les algorithmes d'octroi de crédit peuvent être biaisés et refuser des prêts à certains groupes, limitant leur accès aux services financiers.

Comment Identifier et Atténuer les Biais

Il existe plusieurs techniques pour identifier et atténuer les biais dans les systèmes d'IA :

- Audit des données : Examiner attentivement les données d'entraînement pour identifier les biais potentiels.

- Équilibrage des données : Ajuster les données d'entraînement pour s'assurer que tous les groupes sont correctement représentés.

- Débiaisage des algorithmes : Modifier les algorithmes pour réduire leur sensibilité aux caractéristiques qui peuvent introduire des biais.

- Tests d'équité : Évaluer les performances de l'IA pour différents groupes afin de détecter les biais.

- Transparence : Rendre les processus de décision de l'IA plus transparents afin de pouvoir identifier les sources de biais.

- Diversité : Impliquer des personnes de différents horizons dans le développement et l'évaluation de l'IA pour garantir une perspective plus large.

Exemples Concrets

- COMPAS (Correctional Offender Management Profiling for Alternative Sanctions) : Cet algorithme utilisé aux États-Unis pour évaluer les risques de récidive a été critiqué pour ses biais raciaux.

- Algorithmes de reconnaissance faciale : Ces algorithmes ont été moins performants pour reconnaître les visages de personnes de couleur, ce qui a conduit à des erreurs d'identification et à des arrestations injustes.

- Algorithmes de traduction automatique : Ces algorithmes peuvent reproduire des stéréotypes de genre, par exemple en associant automatiquement certains métiers aux hommes et d'autres aux femmes.

Ce qu'il faut retenir

- Les biais en IA sont des discriminations systématiques et injustes.

- Ils peuvent provenir des données, des algorithmes, de la collecte des données ou de l'interprétation.

- Ils peuvent avoir des conséquences graves dans de nombreux domaines (justice, santé, emploi...).

- Il existe des techniques pour identifier et atténuer les biais, comme l'audit des données, le débiaisage des algorithmes et les tests d'équité.

FAQ

-

Pourquoi est-il si difficile d'éliminer complètement les biais des systèmes d'IA ?

Il est difficile d'éliminer complètement les biais car ils sont souvent profondément enracinés dans les données et les processus sociaux. De plus, il est parfois difficile de définir ce qui est considéré comme 'équitable' car les définitions de l'équité peuvent varier selon les contextes. -

Quel est le rôle des développeurs d'IA dans la lutte contre les biais ?

Les développeurs d'IA ont une responsabilité importante dans la lutte contre les biais. Ils doivent être conscients des sources de biais, utiliser des techniques pour les identifier et les atténuer, et rendre leurs systèmes plus transparents et auditables. Ils doivent également travailler en collaboration avec des experts en éthique et des personnes de différents horizons pour garantir que leurs systèmes sont équitables et justes.