Numérique et Sciences Informatiques > Algorithmique : Tris et Recherche > Complexité Algorithmique > Notations O, Ω, Θ

Comprendre les Notations O, Ω, Θ : Analyse de la Complexité Algorithmique

Introduction aux notations O, Ω, et Θ, outils essentiels pour évaluer et comparer l'efficacité des algorithmes. Apprenez à les utiliser pour estimer le temps d'exécution et l'utilisation de la mémoire de vos programmes.

Introduction à la Complexité Algorithmique

La complexité algorithmique est une mesure de la quantité de ressources (temps et espace mémoire) nécessaires à un algorithme pour résoudre un problème. Elle permet de comparer l'efficacité de différents algorithmes pour une même tâche, indépendamment de la machine sur laquelle ils sont exécutés. Les notations O, Ω, et Θ sont des outils mathématiques qui fournissent une manière formelle de décrire cette complexité. L'objectif principal est de comprendre comment la performance d'un algorithme évolue à mesure que la taille des données d'entrée augmente.

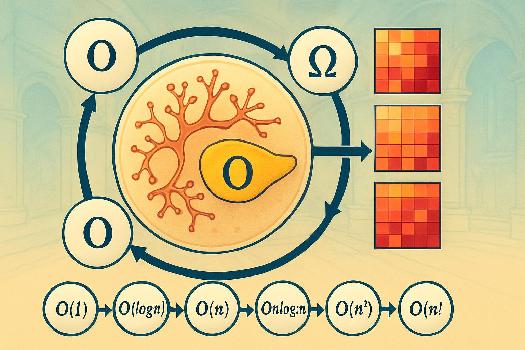

La Notation Grand O (O)

La notation Grand O, notée O(n), représente la limite supérieure de la complexité d'un algorithme. Elle décrit le pire cas possible. En d'autres termes, elle donne une borne supérieure au temps d'exécution ou à l'espace mémoire utilisé par l'algorithme. n représente la taille de l'entrée. Exemple: Un algorithme de recherche linéaire dans un tableau non trié a une complexité de O(n) car, dans le pire des cas, il doit parcourir tout le tableau pour trouver l'élément recherché. Cela signifie que le temps d'exécution de l'algorithme croît linéairement avec la taille du tableau. Formellement, O(g(n)) est l'ensemble des fonctions f(n) telles qu'il existe des constantes positives c et n₀, telles que pour tout n ≥ n₀, f(n) ≤ c * g(n). Exemple concret : Imaginez chercher un mot dans un dictionnaire. Si vous devez parcourir chaque page une par une dans le pire des cas, c'est O(n), où n est le nombre de pages.

La Notation Grand Omega (Ω)

La notation Grand Omega, notée Ω(n), représente la limite inférieure de la complexité d'un algorithme. Elle décrit le meilleur cas possible. Elle donne une borne inférieure au temps d'exécution ou à l'espace mémoire utilisé par l'algorithme. Exemple: Un algorithme de recherche linéaire dans un tableau non trié a une complexité de Ω(1) car, dans le meilleur des cas, il trouve l'élément recherché dès la première position. Cela signifie que le temps d'exécution est constant et indépendant de la taille du tableau dans ce scénario. Formellement, Ω(g(n)) est l'ensemble des fonctions f(n) telles qu'il existe des constantes positives c et n₀, telles que pour tout n ≥ n₀, f(n) ≥ c * g(n). Exemple concret : Si vous cherchez un mot dans un dictionnaire et que vous le trouvez à la première page, c'est Ω(1), car vous avez terminé très rapidement.

La Notation Grand Theta (Θ)

La notation Grand Theta, notée Θ(n), représente la borne exacte de la complexité d'un algorithme. Elle décrit le cas où la complexité de l'algorithme est à la fois bornée supérieurement et inférieurement par la même fonction. En d'autres termes, elle donne une indication précise de la croissance du temps d'exécution ou de l'espace mémoire utilisé par l'algorithme. Exemple: Un algorithme de recherche binaire dans un tableau trié a une complexité de Θ(log n). Cela signifie que le temps d'exécution de l'algorithme croît logarithmiquement avec la taille du tableau. La recherche binaire divise l'espace de recherche par deux à chaque étape, ce qui la rend très efficace pour les grandes quantités de données. Formellement, Θ(g(n)) est l'ensemble des fonctions f(n) telles qu'il existe des constantes positives c₁, c₂ et n₀, telles que pour tout n ≥ n₀, c₁ * g(n) ≤ f(n) ≤ c₂ * g(n). Exemple concret : Si un algorithme prend toujours exactement le même temps proportionnel à la taille de l'entrée, ni plus, ni moins, alors c'est Θ(n).

Comparaison des Notations

Pour mieux comprendre ces notations, visualisons-les :

- O(n) : Le temps d'exécution peut être inférieur ou égal à n.

- Ω(n) : Le temps d'exécution peut être supérieur ou égal à n.

- Θ(n) : Le temps d'exécution est exactement proportionnel à n.

- O() donne une limite supérieure (le pire cas).

- Ω() donne une limite inférieure (le meilleur cas).

- Θ() donne une limite à la fois supérieure et inférieure (le cas moyen et le pire cas sont similaires).

Exemples de Complexités Courantes

Voici quelques exemples de complexités algorithmiques courantes, classées de la plus efficace à la moins efficace:

- O(1) : Complexité constante. Le temps d'exécution ne dépend pas de la taille de l'entrée. Exemple: accéder à un élément d'un tableau par son indice.

- O(log n) : Complexité logarithmique. Le temps d'exécution croît lentement avec la taille de l'entrée. Exemple: recherche binaire.

- O(n) : Complexité linéaire. Le temps d'exécution croît linéairement avec la taille de l'entrée. Exemple: recherche linéaire.

- O(n log n) : Complexité quasi-linéaire. Le temps d'exécution croît plus rapidement que linéaire, mais moins rapidement que quadratique. Exemple: tri fusion, tri rapide (en moyenne).

- O(n²) : Complexité quadratique. Le temps d'exécution croît au carré de la taille de l'entrée. Exemple: tri à bulles, tri par insertion.

- O(2ⁿ) : Complexité exponentielle. Le temps d'exécution croît exponentiellement avec la taille de l'entrée. Exemple: calcul de toutes les combinaisons possibles d'un ensemble.

- O(n!) : Complexité factorielle. Le temps d'exécution croît très rapidement avec la taille de l'entrée. Exemple: calcul de toutes les permutations possibles d'un ensemble.

Importance de la Complexité Algorithmique

Comprendre la complexité algorithmique est crucial pour choisir l'algorithme le plus approprié pour une tâche donnée. Un algorithme avec une complexité plus faible sera généralement plus efficace pour les grandes quantités de données. Cela est particulièrement important dans les applications où la performance est critique, telles que le traitement de données massives, la simulation scientifique, et le développement de jeux vidéo. En comprenant comment un algorithme se comporte avec différentes tailles d'entrée, on peut optimiser le code pour des performances maximales.

Ce qu'il faut retenir

- La complexité algorithmique mesure l'efficacité d'un algorithme en termes de temps et d'espace mémoire.

- La notation Grand O (O) représente la limite supérieure (pire cas).

- La notation Grand Omega (Ω) représente la limite inférieure (meilleur cas).

- La notation Grand Theta (Θ) représente la borne exacte.

- Il est crucial de comprendre ces notations pour choisir l'algorithme le plus approprié pour une tâche donnée.

- Les complexités courantes incluent O(1), O(log n), O(n), O(n log n), O(n²), O(2ⁿ) et O(n!).

FAQ

-

Quelle est la différence entre O(n) et Ω(n) ?

O(n) représente le pire cas (la limite supérieure), tandis que Ω(n) représente le meilleur cas (la limite inférieure). O(n) nous dit que l'algorithme ne prendra jamais plus de temps que n, tandis que Ω(n) nous dit qu'il ne prendra jamais moins de temps que n dans le cas le plus favorable. -

Pourquoi est-ce important de connaître la complexité algorithmique ?

Connaître la complexité algorithmique permet de choisir l'algorithme le plus efficace pour un problème donné, surtout lorsque l'on travaille avec de grandes quantités de données. Cela peut avoir un impact significatif sur la performance de votre programme. -

Comment puis-je déterminer la complexité d'un algorithme ?

Pour déterminer la complexité d'un algorithme, vous devez analyser le nombre d'opérations élémentaires (comparaisons, affectations, etc.) effectuées en fonction de la taille de l'entrée. Identifiez les boucles et les instructions qui sont exécutées le plus souvent et déterminez comment leur nombre d'exécutions dépend de la taille de l'entrée. La complexité est généralement exprimée en termes de la plus grande contribution à la croissance du temps d'exécution ou de l'espace mémoire.